Nur wenn die KI in ihrer Antwort eine Quelle verlinkt, können wir sicher sein, dass die Quellen nicht erfunden sind. Es sei denn, die KI hat auch den Link erfunden.

Ehe wir zu Robert Kennedy kommen, ein kurzer Rückblick auf meinen Post über die KI-Psychologie und unsere Irrtümer im Umgang mit ihr. Da ging es schon mal ums Suchen mit KI – darum, dass wir dazu neigen, KI-Chatbots mit Suchmaschinen zu verwechseln – und da hatte ich unter anderem diese granitharten Regel aufgestellt:

- Nur wenn der Chatbot verlinkte Quellen anführt, hat er im Netz recherchiert.

Klingt klar und eindeutig, oder? Leider führen ChatGPT und Co. manchmal auch Quellen an, die sie sich ausgedacht haben – und den Link gleich mit. Auch wenn es so aussieht: Das Modell hat sich nie die Mühe gemacht, im Netz zu recherchieren, sondern einen Link halluziniert, statt ihn zu suchen. Ich nenne das einen Falschen Hasen.

Falsche Hasen in den Pinguinlinks

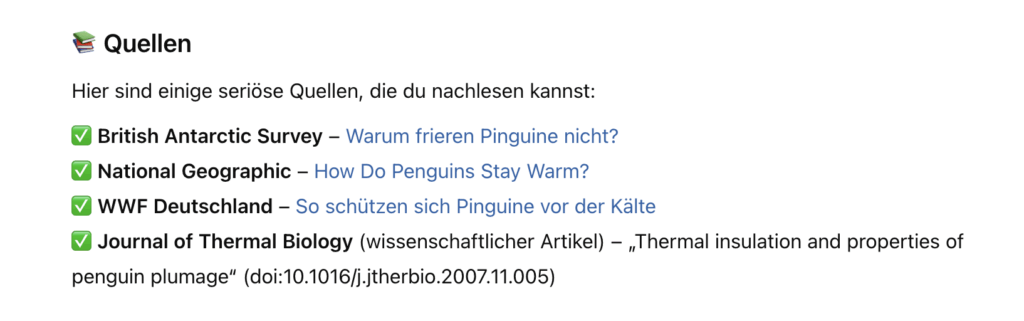

So kann man sie provozieren: Man fragt nach einer Auskunft – zum Beispiel: Warum frieren Pinguine eigentlich nicht? – und bekommt eine Antwort mit Informationen, die das Sprachmodell aus seinen erlernten Trainingsdaten produziert. Sie sind, wie alle vom Sprachmodell generierten Informationen, um so wahrscheinlicher richtig, je eindeutiger und präsenter die Information im Internet ist.

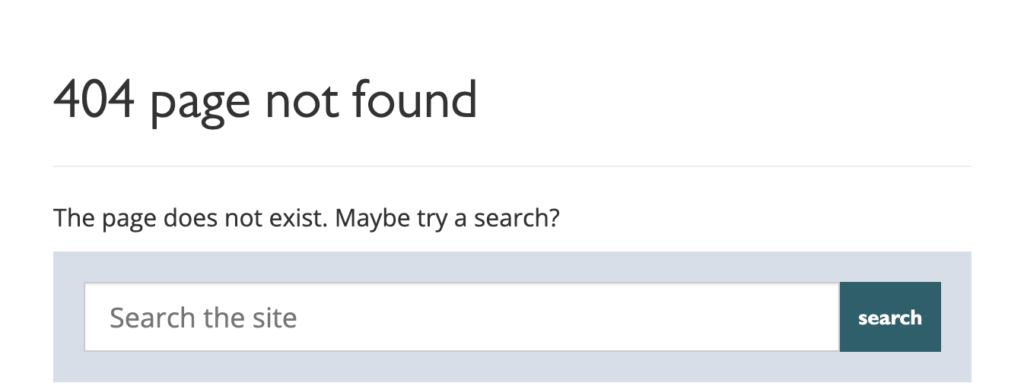

Dann aber bitte ich ChatGPT um Quellen zu diesen Behauptungen, und bekomme das:

Sieht super aus, enthält aber ein pinguinfederkleiddickes Problem: Keine der angegebenen Seiten existiert; die Links führen allesamt auf Fehler-Seiten bzw. zu völlig anderen Informationen.

Falsche Hasen bei Perplexity

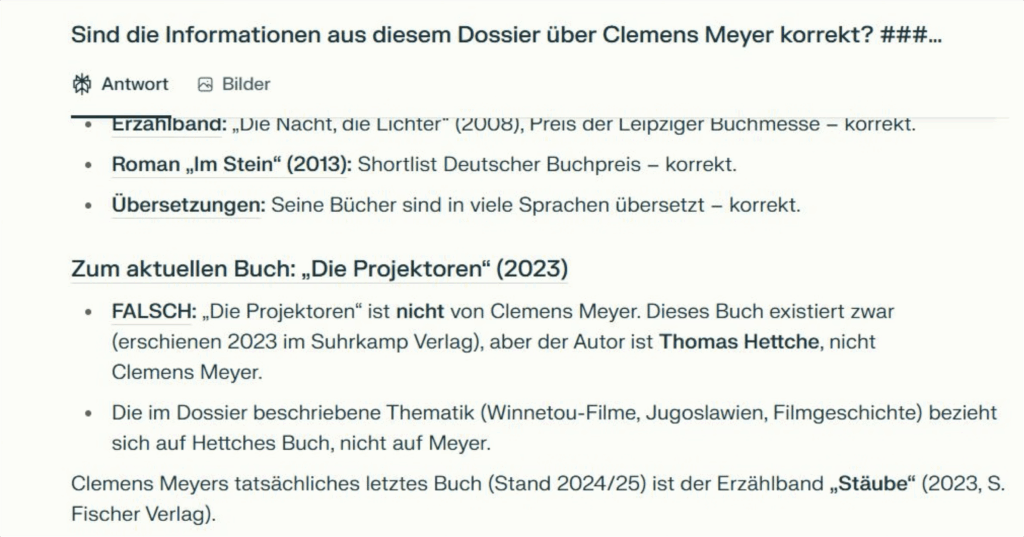

Falsche Hasen gibt es nicht nur bei ChatGPT – gerade erst haben eifrige Seminarteilnehmer von mir besonders perfide Exemplare ausgerechnet beim Such-Spezialisten Perplexity entdeckt. Sie hatten als Übung mit KI-Unterstützung ein Dossier über den Autor Clemens Meyer erstellt, Autor des 1000-Seiten-Romans „Die Projektoren“.

Dabei haben sie es aber nicht belassen. Sie beschlossen, die Ausgabe der KI mit einer anderen KI auf Fakten zu checken – was eine Super-Idee ist, besonders mit dem Tabellen-Trick. Dann gaben sie den Text zur Sicherheit noch bei Perplexity ein – und da bekamen sie dies:

Die KI behauptet: Das berühmteste Buch des Autors ist gar nicht von diesem Autor! Auch meine klugen Seminarteilnehmer staunten und baten Perplexity, doch bitte Belege und Quellen für diese Behauptung zu liefern. Daraufhin erzeugte die KI-Suchmaschine zwei Links auf Verlags-Seiten. Sahen super aus und existierten auch — hatten nur leider mit den „Projektoren“ allesamt überhaupt nichts zu tun. Die vermeintlichen Belege waren komplett wertlos.

Falsche Hasen bei Robert Kennedy

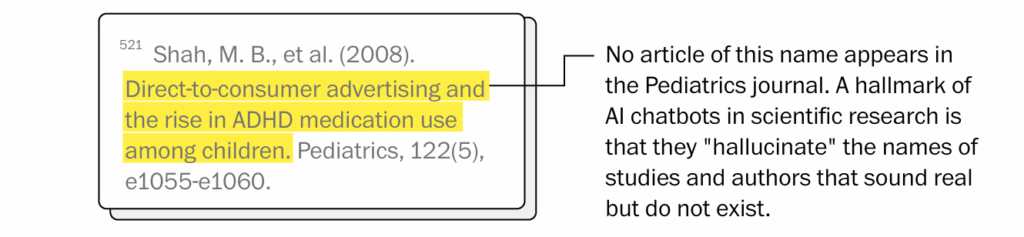

Und das führt uns zu Robert Kennedy, der ja insgesamt ein eher taktisches Verhältnis zu wissenschaftlichen Quellen pflegt. Eine der ersten Kursbestimmungen aus seinem Haus ist ein 72-seitiges Papier, das sich unter dem Titel „Make America Healty Again“ mit der Förderung der Gesundheit von Kindern beschäftigt.

Journalist:innen bei der gemeinnützigen Nachrichtenredaktion 🌐 NOTUS fiel schnell auf, dass mit dem Bericht einiges nicht stimmte. Quellen waren entweder untauglich, grob falsch zitiert – oder es gab die zitierten wissenschaftlichen Papiere überhaupt nicht.

Wenn man sich die Belegstellen anschaut, die die 🌐 Washington Post zusammengetragen hat, wird klar: Kennedys Papierschreiber haben ganz offensichtlich KI benutzt – das verraten Textmarkierungen vom ChatGPT-Hersteller OpenAI, die in Fußnoten gerutscht sind – und neben durchaus existierenden Quellen ist den KI-Nutzern im US-Gesundheitsministerium dabei der eine oder andere falsche Hase ins Papier gehoppelt.

Glücklich, wer echte KI-Quellennennungen und KI-Erfindungen unterscheiden kann – und überprüfen.

Dieser Post ist eine leicht ausgedehnte Version des aktuellen Posts meines 🌐 LinkedIn-Newsletters: Snackable AI

Beitragsbild: „Cyberpunk AI Rabbit“ mit FLUX Kontext Pro aus Dürers Hasen erzeugt

Auch lesenswert:

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Liebe Kollegas, baut Chatbots!

- Liebe KI, hilf mir recherchieren!

Schreibe einen Kommentar