Krass: Eines Tages kann ChatGPT plötzlich Bilder lesen – nachweislich!1!11!! Angestoßen durch eine Schwärmerei im „Boolean Strings“-Suchnewsletter habe ich mir ein Agenturfoto einer pro-russischen Demo in Moldau auf tagesschau.de geschnappt, die URL, also den Link zum Bild, kopiert, und GPT-3.5 gesagt:

Analyze: https://www.tagesschau.de/multimedia/bilder/moldau-demonstration-pro-russisch-101~_v-gross20x9.jpgUnd ChatGPT legt los:

So viele Details! Ich bin überzeugt: Da ist heimlich ein neuer Skill frei geschaltet worden. Ist das gerade brandneue größere Schwestermodell GPT-4 nicht angeblich multimodal, kann also Bilder lesen und verstehen? Offensichtlich kann GPT-3.5 das auch – toll.

Multimodalität ist etwas, was das kleinere deutsche Konkurrenz-Modell von Aleph Alpha schon beherrscht: Es kann Bilder als Teil des Prompts auswerten und beispielsweise die Objekte in einem Foto benennen. GPT-4 soll das inzwischen auch können – auch wenn für uns Normaluser diese Möglichkeit noch nicht freigeschaltet ist.

Wer jetzt begeistert zur Konsole gerannt ist und es ausprobiert hat: Das Beispiel funktioniert seit dem letzten Update nicht mehr. Und GPT-3.5 weist klar darauf hin: es hat auch vorher nicht funktioniert.

Nichts Bildanalyse. Das Sprachmodell hat die Beschreibung aus der URL halluziniert. Das habe ich dann am Ende – nach viel gutem Zureden von deutlich schlaueren Menschen als ich – auch kapiert, nachdem ich in der URL das Wort „Moldau“ durch „Russland“ ausgetauscht hatte. Die URL, der Bild-Link, wird dadurch ungültig; dahinter steckt dann weder ein Bild noch ein Alt-Text, den das Modell lesen könnte. Trotzdem antwortet es voller Selbstvertrauen:

Es ist nämlich mitnichten so, dass GPT-3.5 das Tagesschau-Bild lesen konnte. Aber ich wollte es unbedingt glauben.

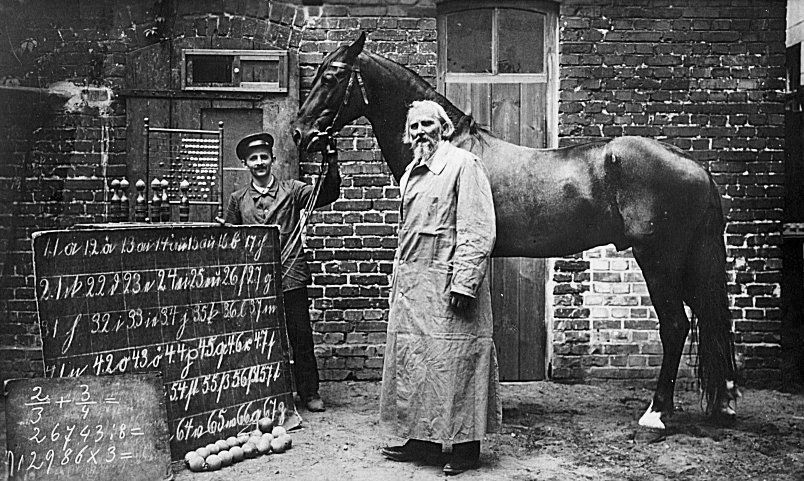

Der „Kluge Hans“ – wenn ein Wunder unwiderstehlich wird

Auch Wilhelm von Osten, Schulmeister im Ruhestand, wollte unbedingt glauben, dass sein Orlow-Traberhengst nach jahrelangem geduldigen Training lesen, schreiben und rechnen konnte. Im Deutschland Kaiser Wilhelms sorgte das talentierte Pferd für so viel Aufsehen, dass eine wissenschaftliche Untersuchungskommission den Fall untersuchen und Betrug ausschließen sollte. Ein unglaublich gewitzter Student, Oskar Pfungst, konnte schließlich nachweisen: Das Pferd konnte nur richtig reagieren, wenn es die Experimentatoren sah, und wenn die die Antwort kannten. Der „Kluge Hans“ reagierte in Wahrheit auf die Signale, die ihm sein Lehrer und die anderen Menschen rundherum unwillkürlich gaben.

Wie die KI, die aus den Worten im Bild-Link ableitete, was ich hören wollte.

Ich bin also nicht der erste, dem so was passiert. (Auch wenn ich eigentlich genau wissen sollte, was ein Bestätigungsirrtum ist – mein Zettelkasten der kognitiven Verzerrungen hier.) Ich wollte es glauben, dass die KI etwas kann, was sie gar nicht konnte. Hatte es nicht schon bei „Boolean Strings“ mit einem extra neu erzeugten Midjourney-Bild geklappt? Und dass, obwohl ich doch weiß, dass die Modelle stimmigen Unsinn erfinden können.

Nicht das Pferd, nicht die KI, ist das Problem in dieser Geschichte – wir sind es. Notiz an mich selbst: Nie unterschätzen, wie glaubhaft die Sprachmodelle auftreten, auch und ganz besonders, wenn die Ergebnisse nicht mit der Wirklichkeit übereinstimmen. Es sind nun mal Text-Vorhersagemaschinen, keine Konversationspartner, die über unsere Frage nachgedacht haben.

Kleiner Techniktrost: Mit der Frage, was die KI tatsächlich berücksichtigt, wenn sie uns eine Antwort liefert, beschäftigt sich die hoch spannende Forschungsdisziplien der „Explainability“. Mehr dazu – und ein paar sehr authentische Pferdewieherer – in diesem Podcast/Feature für hr-iNFO. (Link: ARD-Mediathek, Manuskript mit Fußnoten und Links als Google Doc.)

Schreibe einen Kommentar