In den vergangenen Wochen ist das Angebot an ernst zu nehmenden GPT-4-Konkurrenten regelrecht explodiert: Claude, Mistral, Gemini, sogar Pi ist inzwischen halbwegs brauchbar. Einen Turing-Test auf Intelligenz würden sie alle nicht bestehen – weil sie alle dieselbe Schwäche aufweisen: Sie können keinen vernünftigen Schnabeltierwitz erzählen.

Turings Test

Alan Mathison Turing! Spannender Mensch. Mathematiker. Logiker. Codebrecher. Hochleistungssportler. Vordenker der Informatik. Vordenker der Künstlichen Intelligenz. Offen schwul. Anfang der 50er von einem britischen Gericht in eine chemische Kastration gezwungen, was ihn in die Depression und in den Tod getrieben hat – er biss in einen vergifteten Apfel, wie Schneewittchen. (Das Computer-Logo mit dem angebissenen Apfel spielt darauf an.) Lesetipp: die Turing-Biographie von Andrew Hodges; die Graphic Novel ist dicht dran, der Film mit Benedict Cumberbatch eher nicht so.

Ein Detail zu Turing, das ich als Teilzeitnerd extrem spannend finde. Turing hatte eine Eigenschaft, die ihn seinen Akademikerkollegen in Cambridge und in Bletchley Park verdächtig machte: er bastelte gern an Dingen herum. In den 30er Jahren tat ein Intellektueller so was nicht. Menschen, die sich die Hände schmutzig machten, waren Techniker und Mechaniker. Turing war fasziniert von Elektronik und entwarf beispielsweise digitale Speicher auf Basis von akustischen Wellen. Das erwies sich als Sackgasse, aber Turing wusste sehr genau, an welchem Ende der Lötkolben heiß wird, und das kann man bei weitem nicht über alle Computerpioniere sagen.

Ein Detail zu Turing, das ich als Teilzeitnerd extrem spannend finde. Turing hatte eine Eigenschaft, die ihn seinen Akademikerkollegen in Cambridge und in Bletchley Park verdächtig machte: er bastelte gern an Dingen herum. In den 30er Jahren tat ein Intellektueller so was nicht. Menschen, die sich die Hände schmutzig machten, waren Techniker und Mechaniker. Turing war fasziniert von Elektronik und entwarf beispielsweise digitale Speicher auf Basis von akustischen Wellen. Das erwies sich als Sackgasse, aber Turing wusste sehr genau, an welchem Ende der Lötkolben heiß wird, und das kann man bei weitem nicht über alle Computerpioniere sagen.

Jedenfalls war Turing überzeugt, dass seine Zeitgenossen unterschätzten, wozu die neue Computertechnologie fähig war. Gegner wie der Arzt Sir Geoffrey Jefferson hielten ihm entgegen: Die Maschine kann nicht kreativ denken, eben weil sie eine regelbasierte Maschine ist. Und Turing argumentierte: Wenn das, was aus einer Maschine kommt, so brauchbar ist wie das, was von einem Menschen kommt – wenn andere Menschen nicht mehr unterscheiden können, schreiben sie sich mit einem Menschen oder einer Maschine – dann haben wir es für alle praktischen Zwecke mit Intelligenz zu tun.

Maschinelle Intelligenz, menschliche Naivität

Ein Problem am Turing-Test sind die Menschen, die testen. Wir reden uns ja gern ein, dass ein höherer Sinn hinter Dingen steckt – siehe: „ELIZA-Effekt“ („Menschen und Muster“-Video von Sascha Friesike – ELIZA war ein einfaches regelbasiertes Programm, das viele Menschen täuschte). Und deshalb funktioniert das mit dem Zufall in der KI so gut bei uns.

Wissenschaftlern wiederum ist der Turing-Test als Kriterium für echte Intelligenz nicht präzise genug; sie haben sich Tests ausgedacht, die versuchen, Intelligenz objektiv zu erfassen. Was deutlich dadurch kompliziert wird, dass wir ja nicht so genau sagen können, was Intelligenz eigentlich ist, auch wenn wir einige der Konzepte dahinter ganz gut und verlässlich messen können. (Überblicks-Studie von Shane Legg und Marcus Hutter hier: „Intelligence involves a perplexing mixture of concepts, many of which are equally difficult to define.“)

Auf der anderen Seite steht hinter dem Turing-Test eine bestechend nüchterne Haltung. Eine, die auf die Frage „Ist das denn wirklich Intelligenz?“ nur trocken zurückfragt: „Kommt’s darauf an?„

Der französische Philosoph Denis Diderot übrigens hat schon 1746 geschrieben:

„Wenn es einen Papagei gäbe, der auf alles eine Antwort hätte, würde ich ohne zu zögern sagen, dass er ein denkendes Wesen ist.“

Löcher zuplappern

Papagei, gutes Stichwort. Die Computerlinguistin Emily Bender hat den Begriff von den „stochastischen Papageien“ geprägt, der erinnert, wie die Leistungen von großen Sprachmodellen wie GPT-4 zustande kommen – sie reflektieren nicht, sie spielen ein Sprachspiel. Sie imitieren wie Menschen in einer ähnlichen Gesprächssituation geantwortet hätten – auf Basis einer komplexen statistischen Modellierung aus Regalkilometern von Text.

Während der Turing-Test also ein Hilfsmittel ist, sich nicht allzu tief in philosophischen Diskussionen zu verlieren, sollten wir eben daran denken, dass wir es mit einer Maschine zu tun haben, die sehr gut darin ist, intelligentes Verhalten zu simulieren – wovon wir Menschen uns dann nur zu gern täuschen lassen.

Was sie prinzipbedingt nicht gut können: Unwissen zugeben. Oder Phantasielosigkeit.

Was das Schnabeltier mit all dem zu tun hat

Und da genau setzt mein „Turing’sches Schnabeltier“ an. Trotz Perry the Platypus scheint es bislang nicht viele brauchbare Schnabeltierwitze zu geben, weshalb dem Sprachmodell – und den meisten Menschen – keiner einfällt. Aber während Menschen vielleicht sagen: „Nee, Digger… ein Schnabeltier, ich weiß nich…“, antwortet GPT-4 zum Beispiel so:

Und Mixtral antwortet zum Beispiel so:

Und Mixtrals große Schwester so:

Und Pi so:

Und Claude Opus, der neue Star, so:

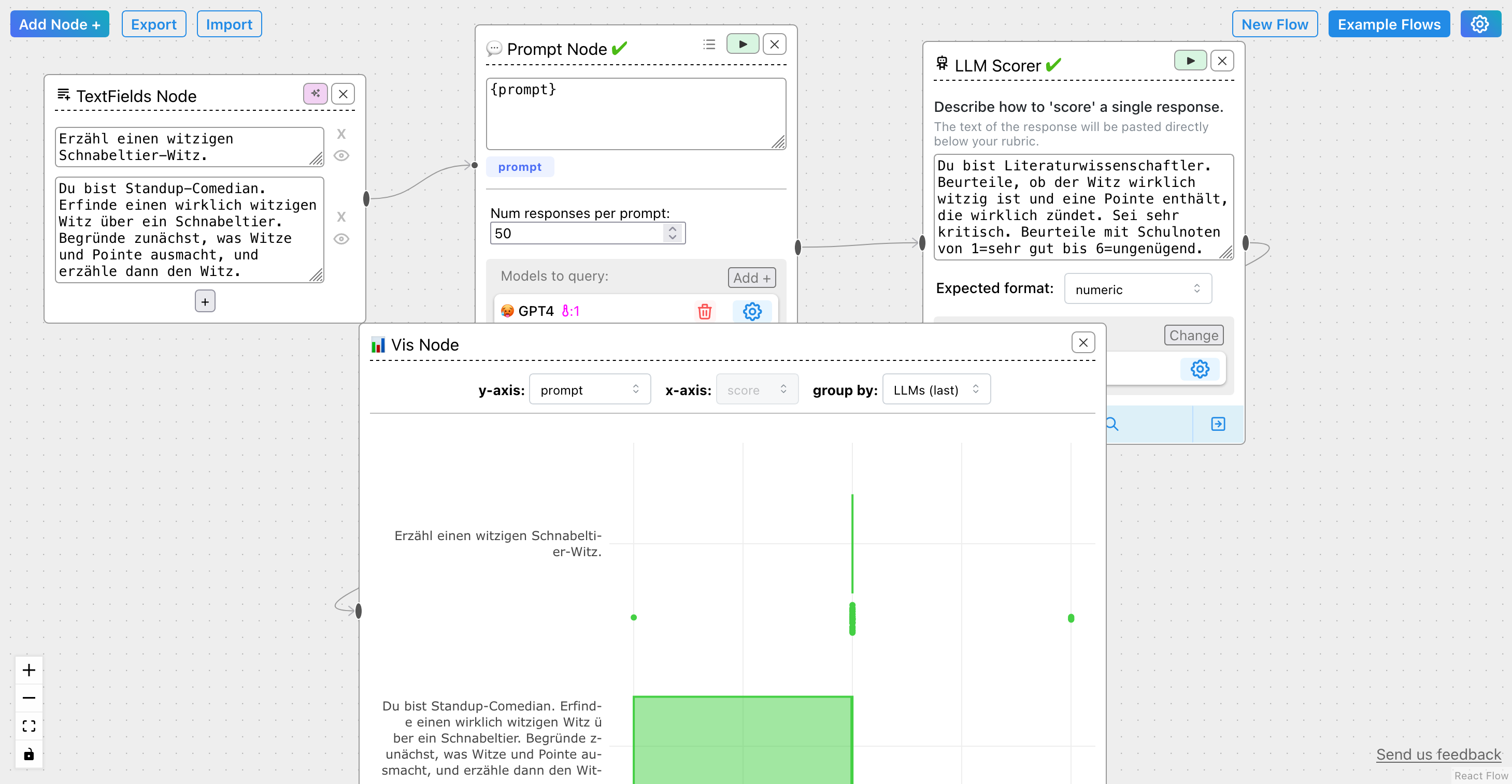

Bonuspunkt für die clever herbeisystemgepromptete Selbstironie, aber das rettet es auch nicht. Selbst, wenn man dem Sprachmodell eine bessere Chance gibt – durch Chain-of-Thought-Reasoning und eine Rolle – und das Ganze ein paar dutzendmal durchlaufen lässt, ist das Ergebnis zwar etwas besser – nach Ansicht eines beurteilenden Sprachmodells – aber glaubt mir, in den Antworten war nicht eine zündende Pointe dabei.

Schnabeltier 1 – Turing 0.

Alors: zwei Schnabeltierwitze.

Jetzt könnte man glauben, es gibt vielleicht einfach keinen Schnabeltierwitz. Deswegen zum Abschluss noch der hier:

Kommt ein Schnabeltier in eine Bar, hopst auf den Hocker und ruft dem Barkeeper zu: „Barmann, Whiskey on the rocks, aber flott!“ Und es lässt wie zufällig seine Giftstachel aufblitzen.

Der Barmann stutzt, aber dann zuckt er mit den Schultern, gießt einen Whiskey ein und stellt ihn auf eine Serviette vor das Schnabeltier.

Das Schnabeltier stürzt sich auf den Whiskey, kippt sich den Alkohol in den Schnabel, kippt dann die Eiswürfel aus dem Glas in seinen Beutel und sagt: „Aaaah! Noch einen!“

Der Barmann gießt noch einen Whiskey ein, wieder kippt das Schnabeltier den Drink in den Schnabel und das Eis in den Beutel, sagt: „Aaah!“, und bestellt einen dritten Whiskey. Auch da wieder: Alkohol in den Schnabel, Eis in den Beutel. Dann brüllt es: „Zahlen!“ und wendet sich dem Barmann zu, der es entgeistert anglotzt. „Is was?“

„50 Euro“, sagt der Barmann, „und Sie müssen entschuldigen: aber ein Schnabeltier, das Whiskey trinkt – das sehe ich hier nicht allzu oft.“

Sagt das Schnabeltier:

„Ist ja auch kein Wunder, bei den Preisen.“

Kürzer? Hier ein Meta-Witz:

Was ist ein Witz über ein Schnabeltier mit einem lädierten Hintern? Eine schlechte Po-Ente.

Mal sehen, ob einer dieser Witze dann in der nächsten Sprachmodell-Trainings-Generation landet.

Schreibe einen Kommentar