Technologie vermenschlichen – das ist einer der großen Fehler, den man machen kann, wenn man sich KI nähert. Ist nicht allein das Wort KI-Psychologie eine Vermenschlichung von KI in ihrer schlimmsten Form? Im Gegenteil – denn auf der Couch liegt nicht die KI, sondern wir.

Mit KI-Psychologie meine ich nämlich Phänomene im Umgang mit KI, die weniger aus der Technik folgen als daraus, wie wir sie wahrnehmen. Die folgenden acht Muster habe ich bei Menschen beobachtet, die KI nutzen:

Irrtum 1: Die KI für einen Zauberstab halten

„Jede hinreichend fortgeschrittene Technologie ist von Magie nicht mehr zu unterscheiden.“ (Arthur C. Clarkes 3. Gesetz 🌐Wikipedia)

Harry, der Zauberlehrling, hat einen Zauberstab, der ihn magische Schwerstarbeit tun lässt: Beim „Vingardium Leviosa!“ muss er nur grob in die Richtung des massiven Wandschranks witschen und wuschen, und das schwere Möbel erhebt sich in die Lüfte. Dabei hilft, dass der Zauberstab genau weiß, was Harry will: Die Kraft, die den Schrank hebt, hebt auch wirklich nur ihn – und nicht die Wandteller, die direkt daneben an einem Nagel hängen. Der Zauberstab weiß auch genau, wie weit Harry den Schrank anheben will, damit er nicht in die Decke rummst — und umkippen soll das gute Stück ja auch nicht; auch das scheint der Zauberstab richtig umzusetzen. (Es ist alles so viel einfacher, wenn man zaubern kann.)

Kein Wunder, sagen Fantasy-Kenner, in Wirklichkeit zaubert der Zauberstab ja nicht, er fokussiert ja nur die mentale Energie des Zauberers; aber was hat das jetzt bitte mit KI zu tun?

Dies: Ohne es uns jemals eingestanden zu haben, glauben wir das von ChatGPT und Co. auch: dass die Maschine wie ein Zauberstab wissen kann, was wir wollen. „Nenn mir die drei wichtigsten Boybands“ – hey, als ich das eben ausprobiert habe, nannte mir ChatGPT doch tatsächlich die Beatles. Neinnein, das war nicht das, was ich meinte! Eigentlich dachte mir… ihr seht, worauf ich hinaus will?

Merke: Die KI kann keine Gedanken lesen. Sie weiß weder, was du vorhast, noch was du eigentlich meinst.

Irrtum 2: Die KI für einen Bordcomputer/-androiden halten

Computer kennen wir seit langem; wir wissen, dass es Maschinen sind, die sehr zuverlässig und genau Daten verarbeiten. Und die Computer der Zukunft kennen wir auch: von der Enterprise.

An Bord des Raumschiffs „Enterprise“ herrschen andere Verhältnisse als beim Zauberlehrling Harry: Magie bleibt außen vor (meistens), dafür gehorcht ein dienstbarer Bordcomputer aufs Wort und liefert Captain Picard und seiner Crew auf Zuruf sekundengenaue, hoch aggregierte und vor allem präzise Daten. Und wenn die mal nicht weiterhelfen, fragt er seinen Androiden-Offizier Data – der ebenso präzise und schnell genau das liefert, was der Captain braucht: Schnell modulierende Schildfrequenzen! Eine Analyse des Spektralfelds! Die historischen Daten der Anomalie im Gammaquadranten!

Wenn wir wiederum die KI etwas fragen, erwarten wir, dass sie die entsprechenden Daten abruft. Die sind entweder in der Datenbank – dann kriegen wir sie zitiert. Oder eben nicht, dann sagt uns der Computer das. So kennen wir sie, unsere Computer – in der Bibliothek, am Arbeitsplatz, im Ordnungsamt.

Aber so funktionieren LLMs, die großen KI-Sprachmodelle hinter ChatGPT und Co, leider nicht. Als Textvorhersage-Maschinen sind LLMs eigentlich dafür gebaut worden, menschliche Konversation nachzuahmen und nicht Fakten abzurufen. Wie sie Informationen speichern, haben auch die, die sie bauen, noch nicht bis ins Letzte verstanden; einen Einblick in dieses Forschungsgebiet liefert dieser Artikel vom Claude-Anbieter 🌐 anthropic.com.

Dass diese Informationen oft auf sehr unintuitive Weise unvollständig sind, kann man sich bei dieser kleinen Web-Demo von mir anschauen: Sie stellt einem ChatGPT-Sprachmodell immer genau eine Frage, nach den Familienverhältnissen einer Schauspielerin. Je nachdem, nach welchem Teil der Informationen man fragt, kriegt man mal richtige Antworten und mal falsche.

Dass die KI nicht sagen kann, wer die Tochter der Mutter ist, obwohl es die Mutter der Tochter kennt — das ist technisch gut zu erklären. Zur Mutter von Meret Becker gibt es einfach nicht so viele Texte, das Sprachmodell hat also geringere Wahrscheinlichkeiten, wenn es Worte zu diesem Thema finden soll, und verzweigt auf Worte, mit denen sich Sätze bilden lassen, die zwar richtig aussehen, aber erfunden sind. Halluziniert.

Auch wenn wir das Sprachmodell für uns vor den Computer setzen, müssen wir bedenken, dass die Technik mit Wahrscheinlichkeiten arbeitet und nicht mit Regeln. Ein Computerprogramm wird vom Computer unerbittlich Schritt für Schritt interpretiert, einen Prompt führt die KI mal vollständig und korrekt aus, mal eben auch nicht – und immer ein klein wenig anders. Was zu ziemlichen Katastrophen führen kann, wenn die KI ungeprüft Programme schreibt – ein Beispiel, das richtig teuer hätte werden können, habe ich hier mal erzählt.

Also: Sprachmodelle sind faszinierend, aber sie machen prinzipbedingt Fehler. Und das geht auch nicht weg: Das ziemlich großartige neue ChatGPT-Sprachmodell o3 (derzeit für nur Plus- und Pro-Kunden) ist extrem gut darin, Fragen zu beantworten – aber es halluziniert um ein Drittel häufiger als seine weniger leistungsfähigen Vorgänger. (🌐 Techcrunch)

Um so mehr gruselt es mich, wie häufig dieser Irrtum auftritt: Gerade erst hat eine Unternehmensberatung herausgefunden, dass drei Viertel der Deutschen die Antworten eines KI-Sprachmodells nicht überprüfen. (🌐tagesschau.de) Dabei ist das ein unbedingtes Muss, wenn man sich nicht blamieren will — wie gerade dieser rechtsradikale Politiker herausgefunden hat. (🌐 DLF) Nicht, dass es mich wundert.

Merke: Ein Sprachmodell ist keine Quelle.

Und prompten ist nicht wie programmieren.

Was man tun kann, um nicht in diese Falle zu laufen:

- Mit Halluzinationen rechnen und misstrauisch sein

- Sich nicht darauf verlassen, dass etwas, das einmal geklappt hat, immer wieder klappen wird

- Der KI nicht unüberwacht Aufgaben übertragen

- Die Fähigkeit moderner KI-Modelle nutzen, im Netz nach Quellen zu suchen — dazu gleich mehr.

Irrtum 3: Die KI benutzen wie Google

„Krass, dass die Beatles die wichtigste Boyband aller Zeiten sind!“ – „Wer sagt das?“ – „ChatGPT!“

Das ist die Fortsetzung des Bordcomputer-Fails: ChatGPT erfüllt immer mehr die Rolle der allwissenden Antwortmaschine, die früher Google hatte. Aber Google ist eine Suchmaschine, also ein System, das dazu gebaut wurde, eine möglichst gute Quelle für Informationen zu finden. Ein Sprachmodell ist dafür gebaut, vorherzusagen, wie Menschen antworten würden. Und ja: man kann die beiden Ansätze kombinieren. Aber das geht auch immer wieder schief.

Ja. Fragen ist das neue Suchen. Auch Google baut ja zunehmend auf „AIO“ – die AI Overview, eine KI-Zusammenfassung, die zu fast jeder Recherche ganz oben angeboten wird. Und praktisch alle derzeitigen Chatbots bieten die Möglichkeit, eine Web-Recherche zu nutzen, und deren Ergebnisse in die Antwort einfließen zu lassen. Leider handeln wir uns damit Probleme ein:

- Nicht immer sind die Quellen der KI gute Quellen.

- Nicht immer ist die Zusammenfassung der KI eine gute Zusammenfassung.

- Es ist nicht leicht zu erkennen, wann die KI wirklich ins Netz gegangen ist.

Gerade der letzte Fehler passiert schnell: Immer wieder werfen ChatGPT-Nutzer einfach eine Webadresse in den Chat; erwarten, dass sich die KI die angegebene Seite gründlich anguckt und der Chat das auch wiedergibt. Das ist aber meist nicht der Fall – wenn wir Glück haben, bekommen wir von der KI einen Hinweis darauf, wenn wir Pech haben, eine irgendwie glaubhaft klingende Erfindung.

Darf man ChatGPT, Le Chat oder Gemini als Such- und Recherchemaschine benutzen? Aber ja – mit Köpfchen! Mit dem neuen o3-Modell ist ChatGPT sogar unheimlich gut darin, Informationen aufzuspüren. (Ein sehr lehrreiches Beispiel hat 🌐 Gregor Schmalzried in seinem Blog, der Host des ARD-KI-Podcasts.) Es spricht also nichts dagegen, sich Informationen mit KI-Unterstützung zu suchen. Wenn man im Hinterkopf hat, dass die KI manchmal Informationen aus der Websuche verschlimmbessert – es ist nun mal ein Sprachmodell, keine Wahrheitsmaschine, siehe oben – und wenn man die eiserne Regel verinnerlicht: Schau nach, wann die Informationen aus einer Webrecherche stammen, und wann das Sprachmodell einfach so geantwortet hat (und möglicherweise halluziniert).

Merke: Nur wenn der Chatbot verlinkte Quellen anführt, hat er im Netz recherchiert.

Und dann können und sollten wir überprüfen,

- ob die Quellen auch wirklich gute Quellen sind,

- ob das Sprachmodell sie korrekt ausgewertet und zusammengefasst hat.

Also: Wenn ihr ChatGPT etwas fragt, schaut genau hin, ob der Antworttext Schaltflächen mit den Quellen-Links enthält. So sehen die bei ChatGPT aus:

(Und bitte, Freunde, klappt bei einer o3-Recherche immer auch das „Reasoning“ auf, die Assoziationskette, in der die KI ihre Arbeitsschritte beschreibt und ausführt! Das sollte man sich anschauen, um keine bösen Überraschungen zu erleben.)

So bei Mistral:

So bei Gemini:

Und so bei Claude:

Irrtum 4: Zufall für Absicht halten

Achtung, jetzt fallen zwei Reizworte: Philosophie und Fußball.

Wir können so viel lernen aus einem guten Fußballspiel! Über uns, über Leidenschaft, über das Leben. Und, natürlich, über den Zufall, denn wann welche Mannschaft wie viele Tore schießen kann, hängt von zufälligen Ereignissen und Faktoren ab. Wissenschaft dazu gefällig: bitteschön! (Der Physiker Prof. Ulrich Walter in der 🌐 Welt).

Um so spannender ist, den Fußballreportern zuzuhören, die das Ergebnis nach dem Spiel erklären. Da ist dann von Moral die Rede, von der Motivation durch den neuen Trainer, von Einzelleistungen – vom Zufall eher wenig. Man kann es den Sportjournalistinnen und -journalisten nur ein wenig vorwerfen: Wir Menschen unterschätzen den Zufall systematisch. (Siehe: Kahneman & Tversky 1971 🌐 Researchgate) Und wir Menschen sind nun mal extrem gut darin, uns Ereignisse wegzuerklären, uns eine plausible Geschichte dazu zu erzählen. Auch wenn es diese Geschichte vielleicht gar nicht gibt.

Das fällt uns beim Einsatz von KI häufig auf die Füße, weil generative KI nun mal auf den Zufall setzt: Die Sprachmodelle der großen Chatbots arbeiten mit einer relativ hoch eingestellten Temperatur, die das Modell manchmal auch weniger wahrscheinliche Worte wählen lässt. Das macht die Antwort menschlicher und lässt das Sprachmodell überhaupt erst zu manchen Antworten kommen, aber – es sorgt eben auch dafür, dass die Antworten jedes Mal ein kleines bisschen anders ausfallen. Mehr dazu hier – wie üblich, mit einem kleinen Experiment.

Merke: Der Zufall spielt bei generativer KI eine Riesenrolle.

Was ich tun kann, um nicht in die Falle zu tappen:

- Die beiden nächsten Punkte bewusst vermeiden.

Irrtum 5: Nach einem misslungenen Prompt sagen: Das kann die KI nicht

Irrtum 6: Nach einem misslungenen Prompt sagen: Das kann ich nicht

Der Zufall dreht noch auf andere Weise an unserer Wahrnehmung. Wie sich ein KI-Chatbot verhält, beurteilen wir erst einmal mit den gleichen Mechanismen, die uns die Evolution zur Einschätzung eines menschlichen Gegenübers mitgegeben hat. (Studie von 2023 dazu: 🌐 dl.acl.org )Wenn wir von dem eine Antwort erhalten, greifen Heuristiken, kleine mentale Abkürzungen, die auf Basis der wenigen verfügbaren Daten eine Ersteinschätzung treffen: Die Antwort ist komplett unbrauchbar oder an der Frage vorbei? Dann ist etwas schief gegangen – entweder bei uns, oder beim Gegenüber. Dabei können wir einfach Pech gehabt haben. Wie gesagt: den Zufall unterschätzen wir ständig.

Andere Dinge sind vielleicht nicht zufällig, aber für uns nicht vorhersehbar — kleine Änderungen in einem Prompt können gewaltige und unvorhersehbare Auswirkungen haben; die Wissenschaftler der großen Meta-Studie zum Prompten hat eine solche kleine Änderung zum Stoßseufzer veranlasst, Prompten sei ja dann doch immer noch eine schwarze Kunst. (🌐 dl.acm.org)

Merke: Wenn etwas nicht funktioniert hat – oder wenn etwas funktioniert hat –

sollte ich daraus nicht auf die Fähigkeiten der KI schließen.

Was ich tun kann, um nicht in die Falle zu tappen:

- Experimentieren. Dinge mehrfach ausprobieren, in Varianten. Die Ergebnisse beobachten – und wenn es darauf ankommt: systematisch auswerten.

Irrtum 7: Etwas glauben, weil’s ein Bild gibt.

Pics, or it didn’t happen! Wenn ich dir glauben soll, zeig’s mir! Ein guter Grundsatz. Leider können wir den Bildern immer weniger trauen. Bildgeneratoren liefern uns Stand- und Bewegtbild von Ereignissen und Dingen, die es so nie gegeben hat. Dabei patzt die KI praktisch überhaupt nicht mehr. Fake! Und natürlich setzen Marketing-Manipulatoren, Betrügern, Populisten und Diktatoren die neue Technik gerne ein.

Das Problem liegt dabei meiner bescheidenen Meinung nach weniger auf der Erzeuger-Seite, bei den Finsterlingen, die mit absichtlich gefälschten Bildern versuchen, unsere einfach zu beeindruckenden Gemüter zu manipulieren, sondern eher bei uns, den Nutzern. Das Beeindruckende an vielen KI-Fakes ist nicht, wie gut sie sind, sondern eher: dass sie schlecht sind und trotzdem geteilt werden. I want to believe! Damit können wir, glaube ich, aber eigentlich ganz gut umgehen; dass die schönen Werbe-Bilder oder der vermeintliche Aufreger aus der Whatsapp-Gruppe von Tante Margarethe nicht echt ist, haben wir uns dann auch ohne KI-Detektor meist gedacht.

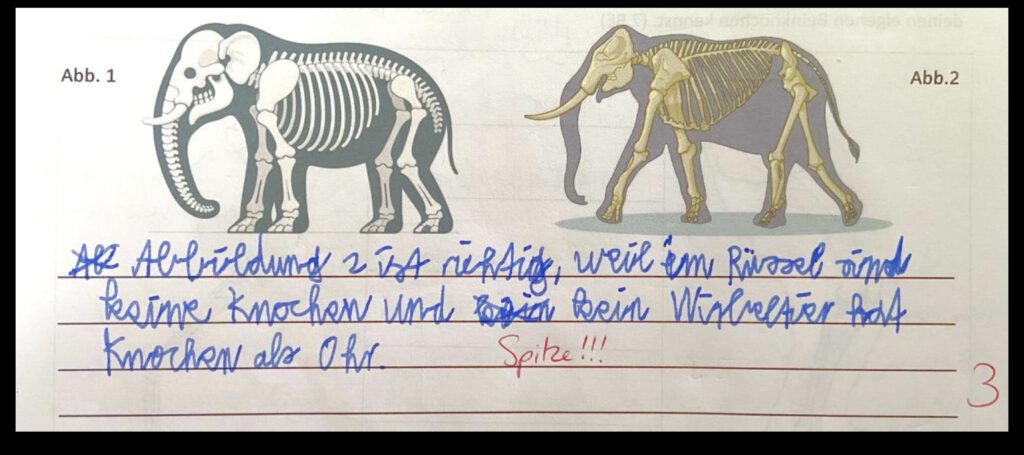

Was wir oft übersehen: dass der „Slop“, der KI-generierte Unsinn, inzwischen auch in vermeintlich ganz harmlose Themen eingesickert ist. Bitte um einen Blick auf dieses Suchergebnis, und dann einmal kurz nachdenken: was ist hier falsch?

Die Lösung kann man hier aufklappen. Sie macht ein wenig Mut, finde ich. (Und danke an Maren Burghard 🌐 Linkedin, die das Beispiel ausgegraben hat.)

Hier klicken, um die Lösung zu sehen

Merke: Gehe bei allem, was du bei Tiktok, Instagram oder X findest,

grundsätzlich davon aus, dass es KI-generiert sein kann. Und damit falsch.

Das gilt leider zunehmend auch für Google-Suchtreffer.

Irrtum 8: Die Seele der KI suchen

Das kennen wir alle: Wir vermenschlichen die Maschine.

Damit meine ich jetzt nicht nur, dass wir bitte und danke sagen (was ich ja nach etwas Hin und Her für wenig effektiv halte, auch wenn es durchaus rationale Gründe dafür geben könnte.). Es ist so leicht, das Verhalten der Maschine durch die Brille zu sehen, die wir den Rest des Tages aufhaben: als Verhalten von etwas, das irgendwie tickt wie wir. Bis hin in die Begriffsfindung. Wenn wir bei KI von „Halluzinationen“ sprechen, als ob die KI Drogen nehmen würde. Oder wenn es bei den „Reasoning“-Modellen heißt: „Denke nach“, während sie doch nur Assoziationsketten bilden.

Vermenschlicht ist schnell.

Das muss noch nicht mal was Schlechtes sein. Neulich hat mir ein Seminarteilnehmer erzählt, dass er am liebsten mit der ChatGPT-App arbeitet, weil er da nicht prompten muss, sondern einfach reden kann – und es ihm im Dialog viel leichter fällt, konkrete Aufträge zu erteilen, als wenn er die Anweisungen eintippt. Und so bestürzend manche der Versuche enden, mit moderner KI-Technologie ein Abbild der Seele eines Verstorbenen wiederzubeleben — hier meine Lieblingsgeschichte aus der GPT-Frühzeit (🌐 San Francisco Chronicle) – wenn es hilft, die Erinnerung an den geliebten Menschen wach zu halten, warum denn nicht? Solange wir daran denken, dass wir nur die Simulation einer Textproduktions-Maschine konsumieren.

Nur: es muss uns halt bewusst werden.

Merke: Sprachmodelle sind dafür gebaut worden, menschliches Verhalten nachzuahmen.

Dahinter verbirgt sich kein menschlicher Verstand.

Das hier ist ein Video, das die Schwester eines Getöteten im Prozess gegen den Täter gezeigt hat, um spürbar werden zu lassen, was das Opfer für ein Mensch war. Die ganze Geschichte hier (🌐 spiegel.de)

Auch lesenswert:

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Weshalb du als Mensch mit Gewissen und Verantwortungsgefühl keine KI verwenden solltest (zumindest nicht unkritisch)

- OpenAI und die Urheberrechte: Ist KI trainieren wie Radkappen klauen?

Schreibe einen Kommentar