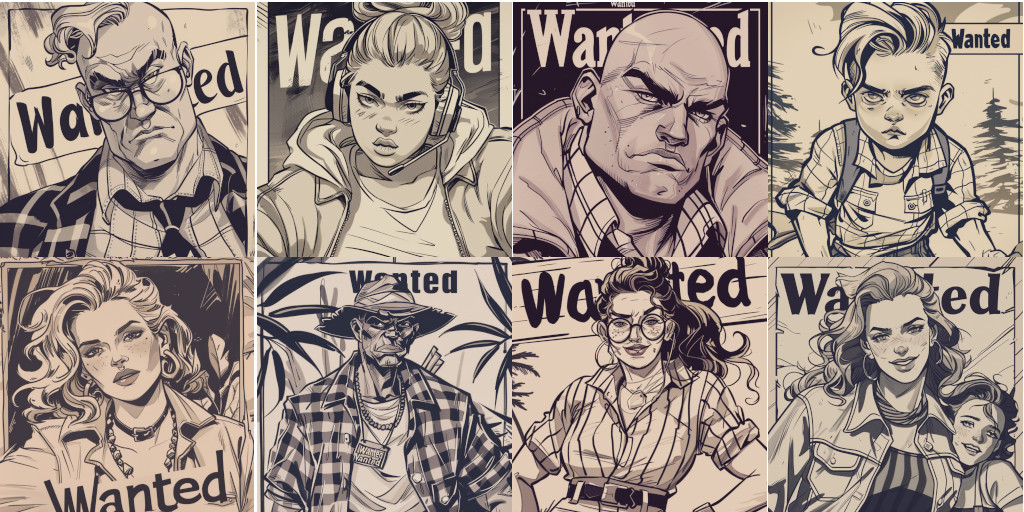

Die KI von ChatGPT soll lernen, sich besser an uns anzupassen – das schafft ChatGPT mit einem bestechend einfachen Trick. Hier erkläre ich ihn – und als Bonus gibt’s den neuen Trick, mit dem Midjourney Bilder in einem vorgegebenen Stil herstellen kann, wie im Beitragsbild oben.

Eine der wichtigsten Dinge, die man über Maschinenlernen wissen muss: dass die einmal trainierten Maschinen nichts mehr lernen. Ob ich in den letzten 30 Chats mit einem Sprachmodell besonders rüde, wissbegierig, neunmalklug war, ob ich mich für Autorennen, Makramee oder Fliegenfischerei interessiert habe – das spielt keine Rolle für meine aktuelle Anfrage; wenn die KI mal so, mal so antwortet, ist das einfach nur Zufall. ChatGPT bildet sich keine Meinung von mir.

Aber das ändert sich gerade. Ein bisschen.

Eine Meinung hat das Sprachmodell natürlich nicht – aber sehr bald wird ChatGPT sich Dinge notieren, die es über uns erfahren hat, und darauf bei weiteren Anfragen reagieren. “Wir erproben, dass ChatGPT die Fähigkeit bekommt, sich an die Inhalte der Gespräche mit dir zu erinnern, um zukünftige Chats hilfreicher zu machen”, schreibt OpenAI dazu (hier der Blogeintrag) – und das schaffen die KI-Ingenieure mit einem einfachen, aber wirkungsvollen Trick.

Erinnerungs-Trick aus der Sprachmodell-Frühzeit

Wie KI-Bots das Problem lösen, dass sie Dinge jenseits der Trainingsdaten wissen müssen, war hier schon mal ausführlich Thema; die Chatbots kriegen eine Datenbank und die Fähigkeiten, einzelne Textblöcke aus dem Archiv zu holen und für die Antwort zu berücksichtigen. Das wäre hier die falsche Technik, weil sie gruselige Folgen haben könnte – wenn wir ChatGPT mal nach Radtouren gefragt haben, wollen wir ja nicht, dass die Maschine sagt: “Sie hatten eine Radtour über die Pyrenäen von Bordeaux über Saint-Jean-Pied-de-Port zum Ibaneta-Pass erwähnt mit genau den folgenden Worten.” Aber mehr so einen allgemeiner Eindruck von uns mitzunehmen – das wäre okay.

Jetzt hilft ein Trick, der in der Sprachmodell-Frühzeit entwickelt wurde. Damals™️ in der Zeit von GPT-3, dem ersten großen Sprachmodell mit der Fähigkeit, menschliche Kommunikation überzeugend nachzuahmen, gab es beispielsweise eine Chatbot-Seite namens “Project December“, auf der man erfundene – oder reale – Personen zum Leben erwecken konnte. Sich mit ihnen unterhalten.

Aber “Project December” hatte mit einem technischen Problem zu kämpfen: GPT-3 hatte 2021 ein relativ kleines Kontextfenster von 2048 Tokens, nicht viel mehr als maximal sechs Schreibmaschinenseiten Text. Und weil ein Sprachmodell eben kein Gedächtnis hat, muss der gesamte bisherige Gesprächsverlauf in diese sechs Seiten passen, inklusive der Beschreibung des Charakters und möglicherweise ein paar “few-shot”-Textbeispielen, an denen die KI sich orientieren kann.

Schnell hatten Bot-Konstrukteure den Trick heraus, auch Teile des bisherigen Gesprächs von der KI selbst zusammenzufassen und in den Kontext packen zu lassen – für eine Art Langzeitgedächtnis. Und in der Charakterbeschreibung beschränkt man sich eben auf eher abstrakte Beschreibungen, die dann auch nicht so viel Platz brauchen. Man kann sie ja ebenfalls von der KI erstellen lassen kann.

Wie überzeugend das werden kann? Dazu möchte ich eine meiner Lieblingsreportagen empfehlen; die herzzerreißende, aber auch schöne Geschichte eines jungen Mannes, der mit dem “Project December” ein Echo seiner toten Freundin wiedererwecken wollte – und dabei mehr Erfolg hatte, als er vertragen konnte. (SF Chronicle)

Von “Project December” zu ChatGPT 2024: Wie läuft es ab?

Bei mir ist der neue “Personalisierungs”-Reiter in den persönlichen Einstellungen noch nicht aktiv, aber nachdem, was ich bisher gelesen habe (unter anderem in diesem Mastodon-Post des Tech-Bloggers Simon Willison) funktioniert das dann so:

- Ich chatte ganz normal mit ChatGPT.

- Die KI schaut auf den Chat und extrahiert einzelne Fakten – beispielsweise: “Hat ein Pferd.”

- Zusätzlich kann ich ChatGPT durch den Befehl

@biobitten, sich Dinge über mich zu merken: dass ich mittlere Vorkenntnisse über Computerprogrammierung habe, zum Beispiel. - All das schreibt die KI in ein personalisiertes “System-Prompt” – eine Rollenbeschreibung, die die KI mit jeder Anfrage als allererstes bekommt. Bei ChatGPT kann man sie normalerweise nicht sehen, Nutzer des “Playgrounds” können testweise selber eine erstellen.

- Bei zukünftigen Antworten werden die Merksätze über mich also in den Kontext übergeben und für die Antwort und den weiteren Chatverlauf berücksichtigt.

Ein wenig gruseln darf man sich darüber schon – auch wenn OpenAI betont: Wir User hätten alles unter Kontrolle und können selektiv wieder löschen. (Was trotzdem nicht heißt, dass Teile unserer Chats nicht im Trainingsmaterial für die nächste KI-Generation landen. Nebenbei: Gemini, die ChatGPT-Version von Google, speichert alle Chats von allen Nutzern drei Jahre lang. Mindestens. – techcrunch)

Die GPT-Assistenten sollen diese Art Gedächtnis übrigens bald auch bekommen. Und übrigens, die Voreinstellung ist: “An”.

Bonustrack: Midjourney mit Stil!

“Kann ich mit KI auch storyboarden?” Das hat mich neulich eine Fernseh-Kollegin gefragt, mit der ich an einem KI-Experiment zu wissenschaftlichen Schrott-Studien gearbeitet habe. Also: kann ich eine Abfolge von Bildern erstellen, nach meinen Vorgaben, aber immer im gleichen Stil?

Bis vor einigen Wochen hätte ich gesagt: gar nicht so einfach, weil der Zufall bei Bildgeneratoren wie Stable Diffusion oder Midjourney eine so große Rolle spielt, dass man kaum zwei Bilder im gleichen Stil hinbekommt; da kann man noch so präzise prompten.

Jetzt kennen Leute, die wesentlich mehr Erfahrung haben mit Bildgeneratoren als ich, dafür einige Tricks. Zum einen kann man mit einem festen “seed” arbeiten, also der Zufallszahl, die bestimmt, von wo aus der Bildgenerator startet. Das sorgt für etwas Stabilität. Zum anderen kann man die Bild-KI nachtrainieren; das Feintuning mündet dann in ein LoRA, ein “Low-Rank Adaptation Model” – eine Stilvorlage für die KI.

Für mich alles viel zu kompliziert! Aber der KI ein Bild geben, von der sie sich den Stil für das nächste Bild abschaut – das kriege ich hin. Und genau diese Möglichkeit bietet mir Midjourney seit ein paar Tagen – die neue Version 6.0 ist allerdings derzeit, fürchte ich, auf Bezahl-Accounts beschränkt.

Sie hat es in sich: Alles, was die KI braucht, ist die URL einer oder mehrerer Bildvorlagen – die man ihr mit dem Befehl –sref <url> übergibt. Dann kann man mit –sw noch bestimmen, wie stark die Vorlage wirken soll, und die neue Midjourney-Version muss man natürlich –v 6 auch einschalten.

Ausführliches Tutorial in diesem Blog.

Die neue Funktion ist in der Midjourney-Hilfe noch nicht dokumentiert – aber jetzt habt ihr alles, was ihr braucht. Have fun!

Auch lesenswert:

- Besser prompten: Gib der KI gut strukturierte ROMANE! Dann gibt sie dir auch die richtigen Antworten.

- Wie funktionieren die GPTs – die neuen KI-Assistenten?

- OpenAI und die Urheberrechte: Ist KI trainieren wie Radkappen klauen?

Schreibe einen Kommentar